por Sebastián Mas

Introducción a la Teoria de la Información

1) Código y Mensaje

Para hacer algunas puntuaciones sobre la teoría de la información de Shannon, es preciso antes familiarizarse con lo que es una función logarítmica. Tal función matemática ha permitido emular de manera muy satisfactoria el comportamiento de una memoria, en la medida en que se toma tal función de recordar como el reencuentro de las cosas. Esta es la base implícita y psicológica de la cual parte esta teoría para hablar de la «comunicación».

¿Cómo podría darse el fenómeno de la comunicación sin un sistema de almacenamiento de información del cual podamos disponer? Shannon demuestra que hay toda una serie de fenómenos detrás y alrededor del mensaje, y la teoría de la información viene a ponerlos de relieve:

«El problema fundamental de la comunicación es el reproducir en un punto exacto o aproximado un mensaje que fue seleccionado desde otro punto. Frecuentemente los mensajes tienen sentido; es decir ya sea que se refieran a o estén correlacionados de acuerdo alguna clase de sistema con ciertas entidades físicas o conceptuales. Los aspectos semánticos de la comunicación son irrelevantes para el problema de la ingeniería.»

(pág. 379, Bell System Technical Journal, «Una Teoria Matemática de la Comunicación» por C. E. SHANNON)

Quizás para el psicoanalítico le sea un poco chocante el hecho de que esta teoría matemática desprecie el carácter semántico de los signos -cosa en la cual estamos todos de acuerdo, es nuestra tarea como analistas escuchar-. No obstante, no es menos cierto que los analistas también deberían interesarse en la sintaxis de los dichos del analizante. Es por eso que el trabajo de Shannon adquiere aquí toda su relevancia, dado que despreciando la semántica, podremos saber ahora la construcción sintáctica de la información.

«El aspecto mas significante es que el mensaje actual es uno elegido de una serie de posibles mensajes. El sistema debe estar diseñado para operar en cada posible selección, no solo aquella en la que va a ser elegida por que esto es desconocido al momento en que nos encontramos diseñando esto.»

(pág. 379, Bell System Technical Journal, «Una Teoria Matemática de la Comunicación» por C. E. SHANNON)

El mensaje es el producto de una serie de posibles mensajes, o como lo llamara Jakobson, de un código. No existe un mensaje que no provenga de un código, dado que es la serie de posibilidades la que habilita la elección y no al revés ¿Qué se podría decir por fuera de esta serie de posibilidades, si no hubiera de donde elegir?

Vemos aquí como se establece una suerte de ley de la conservación de energía, supuesta en este caso para el mensaje. Es decir, ningún mensaje se pierde se pierde realmente por que siempre proviene de un fondo de posibilidades -que es el código-. La actualización o potencia de la información son dos estados que vamos a empezar a discernir de ahora en mas como mensaje (código actualizado) y código (mensaje en potencia).

2) ¿Qué es un logaritmo?

«Si el numero de mensajes en juego es finito entonces este numero o cualquier función monótona de este numero puede ser considerado como una medida de información producida cuando un mensaje es elegido de una serie, donde todas las elecciones son igualmente posibles. Como fue señalado por Hartley la decisión mas natural es la función logarítmica.»

(pág. 379, Bell System Technical Journal, «Una Teoria Matemática de la Comunicación» por C. E. SHANNON)

Un logaritmo es una función matemática que nos ayuda a calcular a que numero tenemos que elevar un numero dado para obtener un determinado resultado. Si quiero obtener el numero 1, entonces puedo empezar elevado a 0 a todos los números naturales, por que cualquiera de esos números elevado a 0, nos da 1.

¿Qué significa esto? En términos mas concretos, esta formula nos da el numero de probabilidades que existen en una serie de ninguna cantidad de elementos -es decir, logaritmo de base 0-. Si no hay ninguna cantidad de elementos, entonces solo hay una posibilidad, no importa cual sea la cantidad de veces que probemos esto. Tal posibilidad monótona, no arroja en realidad ninguna información nueva, se conserva igual a si misma.

Pero cuando pensamos en el logaritmo de base 2, es decir, cuando la cantidad de elementos asciende desde 0 a 2, las posibilidades se dividen exactamente a la mitad. Hay igual cantidad de posibilidades de que aparezca uno u otro elemento. Esto salta inmediatamente a la vista, cuando calculamos el logaritmo de base 2:

- 2 elevado a 0 sabemos que es 1, luego

- 2 elevado a 1 = 2

- 2 elevado a 2= 4

- 2 elevado a 3= 8

Y así sucesivamente el logaritmo de base 2 demuestra que cada vez que se duplican las posibilidades se duplican a su vez la cantidad de elecciones -pese a que la cantidad de elementos sigue siendo la misma-. ¿Cómo podemos hacer que esta información sea mas sencilla?

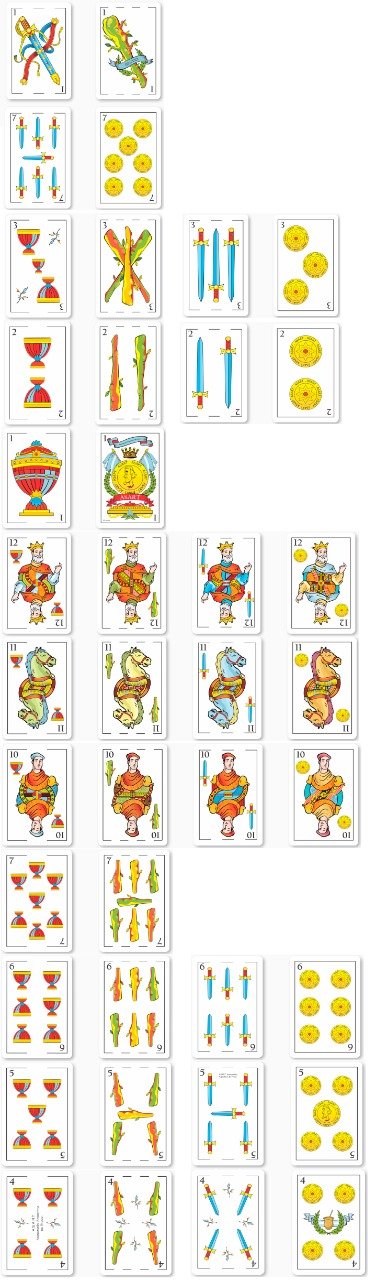

Imagínense que en vez de logaritmo de base 2 sea logaritmo de base 3, y el intercambio de información que queremos medir es el que acontece en el juego del truco. Se reparten 3 cartas a cada jugador, y dependiendo de la cantidad de jugadores será el numero total de cartas en juego por partida:

- Si somos 2, seran 6 las cartas (3 cada uno)

- Si somos 3, seran 9

- Si somos 4, seran 12

- Si somos 6, seran 18

Es decir, si el mazo tiene 40 cartas, entonces cuando jueguen 6 personas el numero de cartas por juego se va a elevar a 18, que es casi la mitad de la cartas que tiene el mazo. La mitad restante tiene casi la misma probabilidad, de aparecer en una u otra partida, si se mezclan las cartas estrictamente al azar…

Hay una escala a tener en cuenta. No todas las cartas son buenas, ya que hay algunas que son malas. La cantidad de cartas malas supera en numero a las buenas, lo cual hace mas difícil que se repartan estas ultimas con mas regularidad que las primeras. Pero este fenómeno aplica solo al nivel de 6 jugadores, dado que con menos cartas en juego por partida, la posibilidades de que se sigan sucesivamente mas malas que buenas no son tan representativas con tan poca información sobre la mesa como cuando son mas jugadores.

Un logaritmo sirve entonces para medir la informacion que un sistema de elementos finitos es capaz de ofrecer. Y con esto, tenemos cierta anticipacion que nos permite predecir que informacion tiene mas probabilidad de aparecer, es decir, si hay ciertos limites que se deberian tener en cuenta para mejorar la tecnica del jugador.

Ahora que ya saben de logaritmos, lo único que le falta es aprender a jugar al truco y ser la sensación entre sus pares y amigos.

«No obstante, esta definición -la función logarítmica de la medida de la información- debe generalizarse considerablemente cuando consideramos la influencia de las estadísticas del mensaje y su rango continuo. En todos los casos usaremos una medida esencialmente logarítmica»

(pág. 379, Bell System Technical Journal, «Una Teoria Matemática de la Comunicación» por C. E. SHANNON)

3) Logaritmo de Base 2: El Código Binario

«La elección de una base logarítmica corresponde a la elección de una unidad para medir información. Si la base 2 es usada las unidades resultantes serán llamadas dígitos binarios, o simplemente «bits», una palabra sugerida por J. W. Tukey. Un dispositivo con dos posiciones estables, tales como un interruptor o un biestable, pueden almacenar 1 bit de información.»

(pág. 380, Bell System Technical Journal, «Una Teoria Matemática de la Comunicación» por C. E. SHANNON)

La elección de 2 como la base logarítmica ideal para el intercambio de mensajes, obedece mas a la necesidad de un dispositivo simple de transmisión y almacenamiento que alguna otra explicación mas psicológica o semántica, no olvidemos que hasta aquí nos hemos abocado a la explicación matemática de la comunicación, desde el punto de vista de la ingeniería.

Pero lo cierto es que el código binario ya existía desde hace mas de 3000 años en la antigua China:

Y lo cierto es también que Gottfried Leibniz ya se había interesado también por los hexagramas del I Ching. Fue una sorpresa para el encontrar que el código de 2 dígitos que venia desarrollando hace unos meses en el 1700, ya habia sido inventado hace mas de 3000 años, es decir, milenios antes del nacimiento de la ciencia moderna.

Tales evidencias ponen de relieve que la comunicación es el fenómeno humano mas antiguo, pero que a su vez el conteo de cantidadades es el modo de comunicación fundamentalmente humano mas primitivo que se ha encontrado.

Es por eso que la decisión de que el código debe partir de dos unidades primigenias, responde a la simpleza que permite a la hora de tener que codificar cualquier clase de información. Volvamos a los hexagramas del I Ching y observemos como su combinatoria se corresponde con la siguiente expresión logarítmica de base 2:

20 = 1

El primer símbolo, o la significación mas fundamental, es aquella que de acuerdo al taoísmo, no puede ser nombrada por que en el momento en que la nombramos deja de ser (por eso es representada aqui por el simbolo del «0»).

21 = 2

Luego, ese símbolo engendra con su división sobre si mismo a dos signos: el ying y el yang. El ying representa el trazo quebrado (-.-) y el yang representa el trazo constante (—). Tal oposición representa la cantidad mínima de elementos que necesitamos para constituir un mensaje o al menos el que necesitaban los chinos para su alfabeto:

23 = 8

Luego a esa oposición de trazos quebrados y constantes podemos reducirla a 8 combinaciones cuando se eleva su exponente hasta el 3. Tomados de a 3, la combinatorio entre el ying y el yang da el resultado de 8 conjuntos, a los que les corresponde el nombre de trigrama -es decir, la mitad del hexagrama-:

Dado que estamos suspendiendo el análisis semántico, lo único que estamos comprobando es la eficacia del código binario para almacenar y transmitir información. El exponente indica el numero de bits que estamos usando -en este caso 3-, y el resultado de posibles combinaciones -en este caso 8- refleja la cantidad de posibles mensajes que podemos construir con dos dígitos.

Si los tomamos de a 4, tendremos 16 posibilidades, 32 si los tomamos de a 5, y 64 es el numero de posibilidades que alberga el alfabeto chino, y es la cantidad de hexagramas con las que trabaja el I Ching -es decir, con una base logaritmica de 2 y un exponente de 6-.

Cuando el logaritmo de base 2 tiene un exponente 6. El equivalente es a 64 hexagramas, y cada uno de ellos funciona como una «letra» en la lengua china

Si este libro de las transmutaciones y del devenir del destino humano parte de 64 hexagramas para realizar sus lecturas oraculares, y en cada lectura hay una probabilidad de recibir solo hasta 6 hexagramas ¿Cuántas tiradas tendriamos que hacer para agotar todas las probabilidades que de acuerdo al I Ching tendria el destino humano? ¿Como se expresaria este razonamiento en terminos matematicos? ¿Seran miles o millones los destinos del hombre?¿Todos esos destinos son posibles?¿O hay algunos que son imposibles?

Sea cual sea la respuesta, lo fundamental es contra lo que nos confronta el I Ching, y es que el destino humano esta sobredeterminadon por la accion de los simbolos. El hecho de que partamos del logaritmo 2, es simplemente por que es la forma mas sencilla de codificar la informacion. Pero es este hecho de sobredeterminacion al que debemos atenernos ante el estudio de cualquier estructura de lenguaje.

Este trabajo es la base para comprender la combinatoria de «El Seminario sobre la Carta Robada» y la estructura topologica de la celula elemental de las cadenas del significante y el significado, formalizadas en el texto «La Instancia de la Letra»·

3 comentarios en “La «Función Logarítmica» como medida de la información en Claude Shannon”